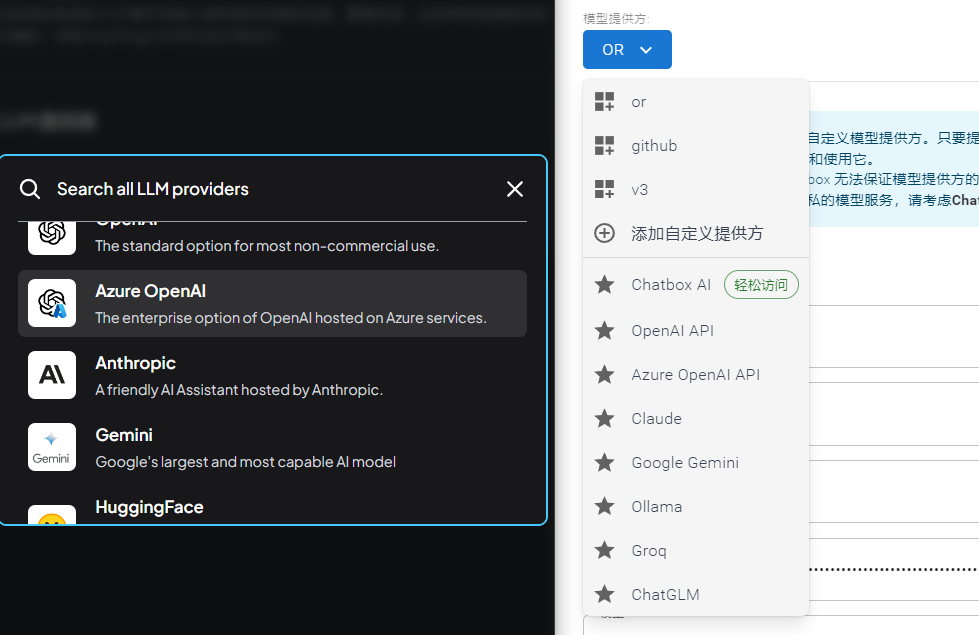

在使用各种ai工具的时候,要么就是在ai工具内进行付费,要么就是提供openai的key,而随着其他模型的快速发展,claude gemeni等也成为一些用户的选择,所以我们现阶段会看到ai应用中会有LLM provider供应商这么个选项:

本文来盘点一下这些供应商,当然提供ai接口服务的供应商非常多,这里列的肯定也是不全的,只是把一些常见的列出来了。

这里openai claude google mistral cohere等我们跳过,因为他们就是模型的原始提供商。

此外ollama lm studio等本地的大模型供应商我们也跳过,就是在自己本机运行的服务。

1 云服务提供商

国内外传统云服务提供商如阿里云、火山云、azure、aws等等,也是ai接口的提供商,尤其是提供了自家研发或者自家扶持的模型,如火山提供豆包,谷歌云gcp提供Gemini、azure提供openai-gpt、aws bedrock提供llama claude等。

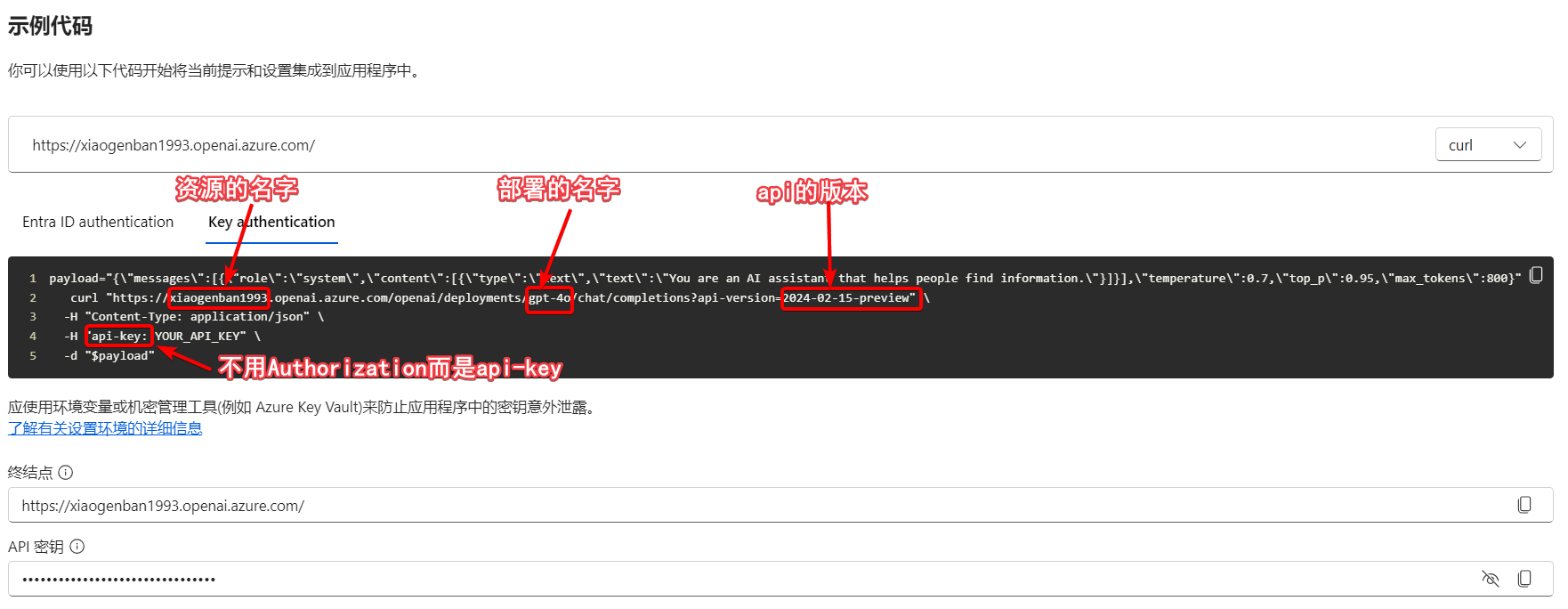

1.1 azure openai

微软azure云,封装了openai的接口,使得整个接口调用变得非常复杂如下,计费和openai一致。

适用群体:

- 中国大陆用户可以调用

azure,绕开openai对国内的限制 - 一直是azure客户的公司

优点:

- 国内可以访问gpt

- 可以进行微调

缺点:

- 使用流程非常繁琐

- 与openai的官方接口不兼容

- 只有openai的模型可用,无法使用

claudellama等其他模型

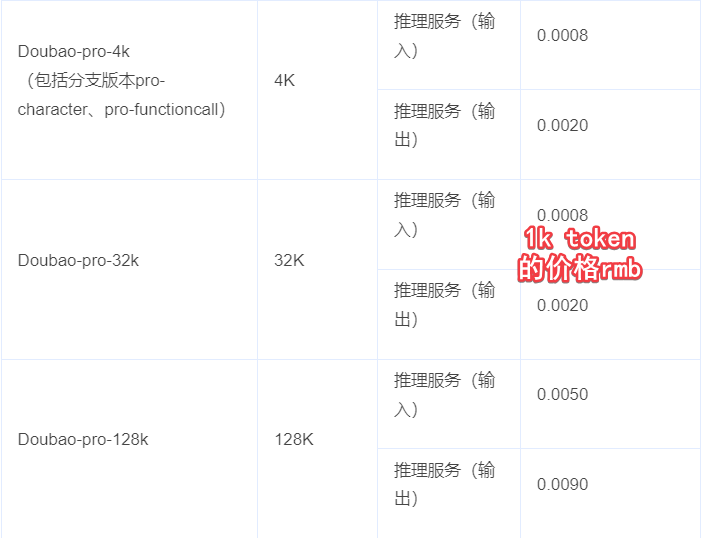

1.2 火山云

火山云主要提供了豆包系列模型,价格比较便宜,并且支持微调。

适用群体:

- 中国大陆用户

- 云服务一般是tob的,所以同样适合一些中小公司

优点:

- 价格便宜,百万token也就1块钱

- 中文能力比

llama等英文向模型强很多 - 方便集成到字节的其他产品如

coze中 - 支持微调,方便企业进行业务定制化模型

缺点:

- 使用流程繁琐,这也是传统云服务商的通病了

- 与openai官方接口不兼容

- 只有豆包和少数几个开源模型,无法使用

gptclaude等业界领先模型。

2 售卖算力的供应商

售卖算力的供应商,主要就是卖gpu资源的,主要售卖的是开源模型,跑在自己的gpu云上,通过不断优化模型、或者优化硬件,来降低成本实现盈利。

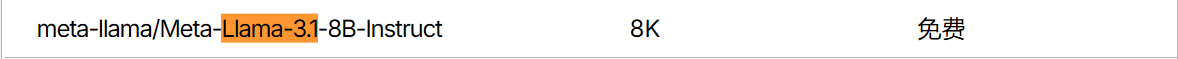

2.1 silicon cloud

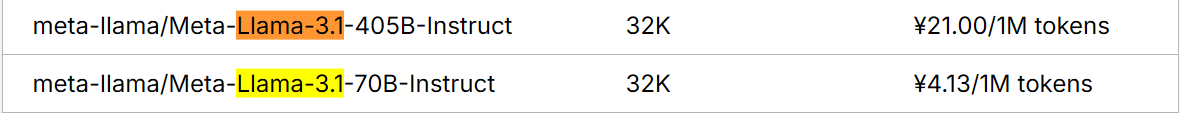

硅基流动,国内的公司,在国内调用非常快,稳定,价格还便宜,10B以下模型都可以免费调用。目前主要是售卖gpu算力,没有开展api代理的工作,所以支持的模型都是开源的。如qwen llama等。llama3.1价格:

使用群体:

- 国内个人开发者

- 中小企业

优点:

- 在国内价格、速度、稳定性各方面优势明显

- 中文页面和中国人习惯

- 提供了世面上优秀的各种开源模型

- 兼容openai的接口

缺点:

- 目前对外提供的模型,都是开源模型,无法调用gpt等模型。

2.2 together ai

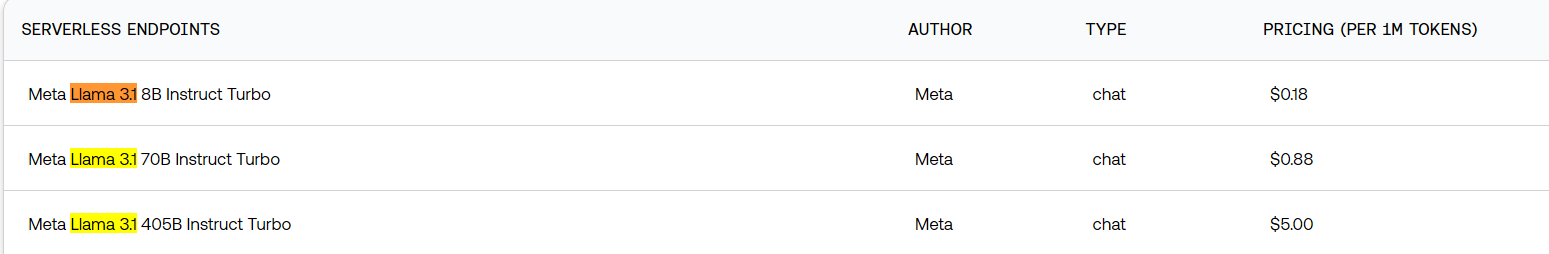

together ai与silicon定位一致,同样是提供开源模型,售卖算力,因为是海外的平台,在价格和速度方面对比silicon就有些没有优势了,所以这里我们直接不展开介绍了,这里只列出llama3.1的价格如下,是turbo版本模型,比硅基贵了不少。

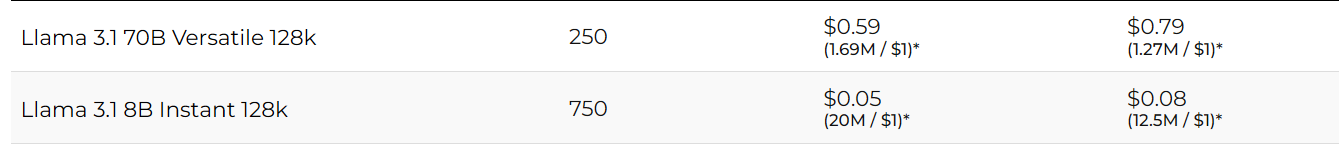

2.3 groq cloud

groq cloud和前面两个定位一致,同样是提供开源模型,售卖算力,是海外平台,同样对比silicon,在价格和速度上没啥优势。

但是groq的优势是输出比较快,基于硬件上的定制化优化,使得回答问题的速度比同行快一些,所以本质上groq是搞硬件的。

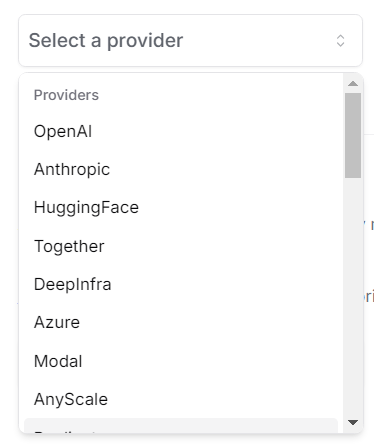

3 代理

还有一类供应商,提供代理的能力,实现套娃,类似一个网关,可以将openai anthropic google等等其他供应商的api汇总过来,进行封装,提供统一的对外endpoint,即只需要接入这一个代理商,就可以在保持大部分代码不动,只修改model参数,就可以自由的在gpt gemini等等模型之间切换了。

3.1 open router

openrouter同时提供闭源三巨头gpt claude gemini三大模型,还有众多模型的供应商,router的名字很贴合。可以使用$1美元的免费额度。

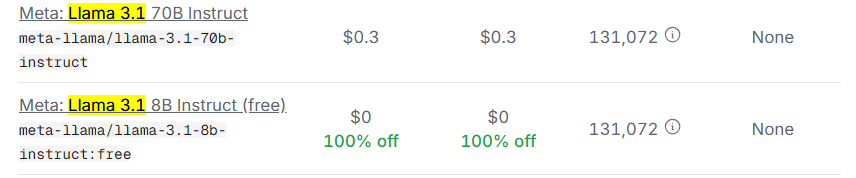

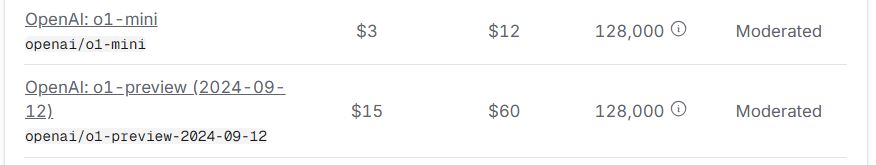

开源llama3.1-70b,百万token 2块钱,甚至比SiliconCloud还低,

闭源模型如gpt是和openai官网价格一致甚至更低,并且已经提供了最最最新的o1模型了。

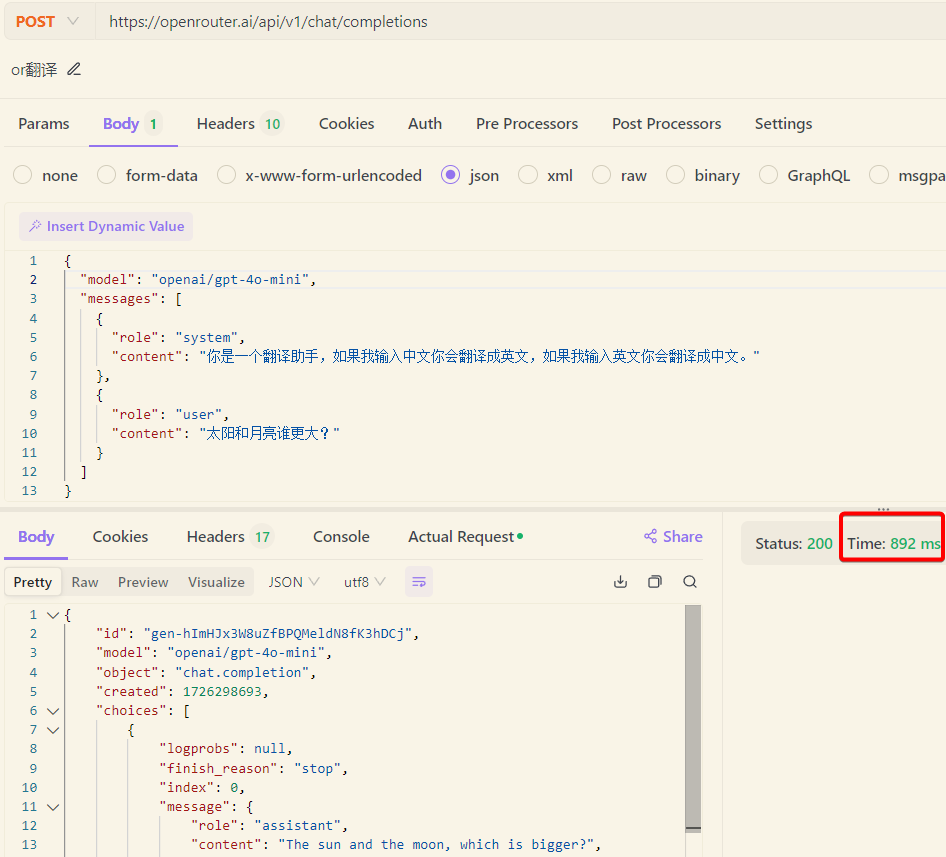

并且从响应速度来看,可能得益于负载均衡的架构,open router也很快。

适用人群:

- 较为广泛,但是国内的公司不太会直接接入外网的服务

优点:

- 包罗万象

- 价格公道

- 兼容openai

缺点:

- 国外的平台,搞不好哪天域名被拉黑。

- 平台的页面做的优点简单

3.2 chatanywhere

chatanywhere国人做的代理服务,我之前一直使用的一个代理服务,gpt4刚出来的时候,提供的3.5的免费token对于个人用户非常友好。主要提供openai模型代理,价格与官网一致,azure线路比官网价格还低一些。

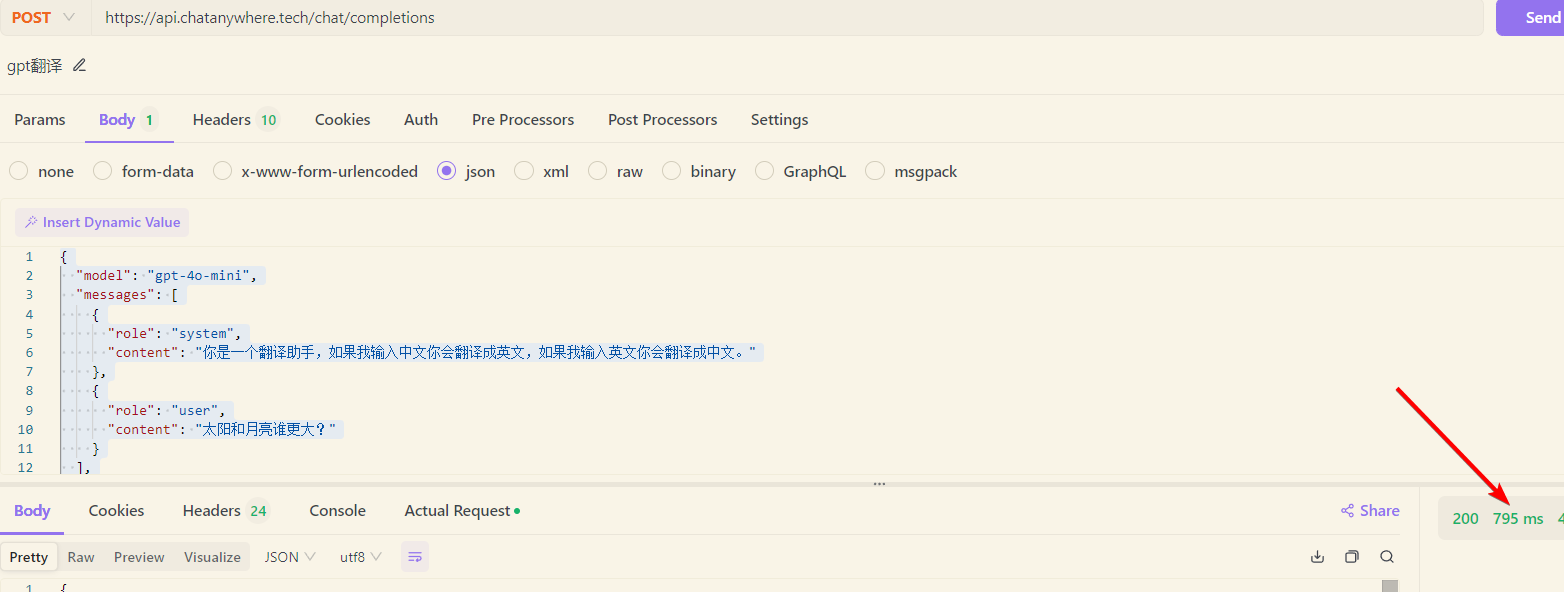

早期是比官网价格低不少的,可能是为了揽客,现在与官网一致,基本是个代理的作用,速度还是很不错的。

适用人群:

- 个人开发者或个人用户

优点:

- 稳定,很少出现问题

- 响应也很迅速

- 早年间的白月光

缺点:

- 只提供了openai的模型和一个

claude-3.5但是后者总是失败 -ca的az线路出现过多次抖动- 对比

openrouter没什么优势

3.3 V3 api

v3与openrouter类似,代理了很多其他供应商和模型,而且是国人做的。

价格标注和官网的是一致的,但是充值的时候,会发现100美元,只需要充值225rmb,换句话说汇率只有2.25左右,天然的有将近3折的优惠价。

适用人群:

- 个人开发者或个人用户

优点:

- 模型很多,跟进很快,

o1刚发布就已经支持了 - 价格便宜,天然3折,并且很多模型不定期还会折上折,例如

gpt部分模型很多时候比官网价格还便宜!! - 国内的模型比较多

- 充值和使用都非常方便

缺点:

- 登录页面每次用github登录,都要重试多次才能登陆,系统页面有种机场的感觉

- 主线路之前出现过多次响应较慢的情况,工单反馈也很难快速解决,总体体量还是较小

- 模型中缺少优秀的开源大模型

4 上述供应商汇总表格

| provider | 国内/海外 | 国内访问速度 | 服务稳定性 | 支持gpt | 支持claude | 其他模型 | 价格(只看output) |

|---|---|---|---|---|---|---|---|

| azure openai | 海外 | 快 | 大厂稳定 | ✔️ | ❌ | - | 对齐官网 4o:¥105/M 4o-mini:¥4.2/M |

| 火山云 | 国内 | 快 | 大厂稳定 | ❌ | ❌ | 豆包 | 128K: ¥9/M 32K: ¥2/M |

| silicon cloud | 国内 | 快 | 本土稳定 | ❌ | ❌ | llama,qwen,deepseek,mistral等 | llama3.1-70B-inst: ¥4.13/M |

| together ai | 海外 | 慢 | 不稳定,官网好像被墙了 | ❌ | ❌ | llama等 | llama3.1-70B-inst: ¥6/M |

| groq cloud | 海外 | 快 | 目前稳定 | ❌ | ❌ | llama等 | llama3.1-70B-inst: ¥5.6/M |

| open router | 海外 | 快 | 目前稳定 | ✔️ | ✔️ | llama等200多个 | 4o: ¥105/M 4o-mini:¥4.2/M llama3.1-70B-inst: ¥2/M 但是有部分税 |

| chatanywhere | 国内(但机器海外) | 快 | 目前稳定 | ✔️ | ✔️ | - | 4o: ¥105/M 4o-mini:¥4.2/M |

| V3 api | 国内(但机器海外) | 快 | 目前稳定 | ✔️ | ✔️ | qwen等 | 4o: ¥40左右/M 4o-mini:¥1.5左右/M |

个人比较推荐openrouter和v3,如果有RAG需求的话,embedding和rerank接口建议使用silicon cloud,目前免费。